У ЄС розробили закони для контролю над штучним інтелектом. Як саме відбуватиметься контроль ШІ в Європі

Нове законодавство описує та зазначає умови використання ШІ на європейському ринку

13 березня 2024 року Європейський парламент ухвалив перший у світі закон про штучний інтелект – документ, що розглядався з квітня 2021 року й нарешті отримав схвалення. Проте на цьому історія лише почалася. Закон набуде чинності у травні, щоб до кінця року жителі ЄС побачили зміни. Регуляторам у всіх країнах єврозони доведеться впровадити норми закону у своїх юрисдикціях, а от компанії матимуть три роки на пристосування до нових правил.

Для бізнесу цей закон – безпосередній чек-лист роботи із ШІ-продуктами на європейському ринку. Враховуючи кількість інвестиційних коштів у галузі штучного інтелекту та кількість продуктів, що їх створюють українські стартапи й компанії, цей перелік вимог їм знадобиться.

Закон про ШІ (AI Act) має на меті надати розробникам ШІ та тим, хто його впроваджує, чіткі вимоги й зобов’язання щодо використання технології. З іншого боку, регуляторний акт має «зменшити адміністративні та фінансові тягарі для бізнесу, зокрема малого та середнього», вважають у Європарламенті.

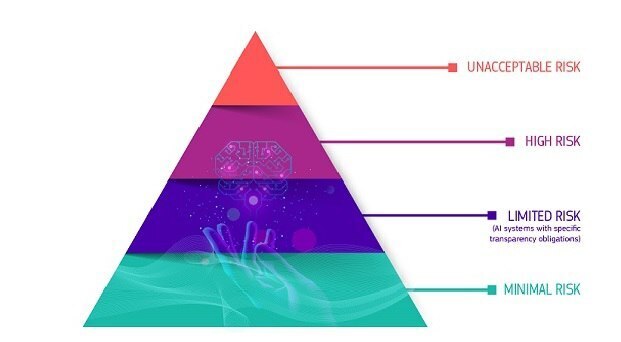

Європарламентарі використали ризик-орієнтований підхід, поділивши рівень ризику систем на чотири рівні. Варто віддати належне брюссельським бюрократам, бо більшість обмежень і регулювань стосуються зони «високого ризику».

Отже, якими є основні нововведення, що їх впроваджує нове законодавство ЄС.

Обмежена (насправді, ні) кількість галузей для застосування ШІ

Закон обмежує застосування ШІ в галузях, у яких технологія може порушити фундаментальні права людини – на кшталт охорони здоров’я, освіти та правоохоронної діяльності. Також обмеження накладаються на продукти із зони «неприйнятного ризику».

Серед них – доволі екстравагантні й неочевидні варіанти на кшталт «маніпулятивних, оманливих і таких, що впливають на свідомість, методів спотворення поведінки та погіршення ухвалення обґрунтованих рішень» або ж експлуатації вразливих верств населення.

Також Закон про ШІ забороняє впровадження систем, що використовують чутливу інформацію – політичні уподобання, сексуальну орієнтацію; неможливе використання в режимі реального часу систем розпізнання обличчя у громадських місцях. Створення баз даних розпізнавання обличчя на основі зібраної в інтернеті інформації (по типу Clearview AI) також під забороною.

Читайте також: Повстання машин скасовується: як у США планують регулювати штучний інтелект

Водночас регулювання у цьому пункті доволі розмите. На відміну від бізнесу силовим структурам дозволено використовувати чутливу біометричну інформацію, як і системи розпізнавання обличчя у громадських місцях, – звичайно ж, лише в разі розслідування особливо тяжких злочинів, як-то тероризм чи викрадення дітей.

Такі «подвійні стандарти» моментально стали об’єктом уваги правозахисників. Наприклад, організація із захисту цифрових прав Access Now невигадливо назвала Закон про ШІ «провалом у справі захисту прав людини».

Чітка ідентифікація ШІ як співрозмовника

Технологічним компаніям доведеться попереджати людей, що вони взаємодіють із чат-ботом чи іншою ШІ-системою. Закон про ШІ також вимагає відповідним чином помічати контент, створений за допомогою ШІ. Це – гарна ініціатива в часи дезінформації та дипфейків, яка сприятиме розвитку технологій нанесення міток і перевірки походження контенту.

Звичайно, це все простіше описати, ніж зробити, і дослідники ще доволі далекі від слідування нормам нового закону. «Водяні мітки» на контенті є дуже молодою технологією, яку легко використати на зло. Все ще по-справжньому складно вирізнити згенерований штучним інтелектом контент. Але деякі розробки вже обнадіюють (наприклад, відкритий інтернет-протокол С2РА), але для формування індустріальних стандартів верифікації походження контенту, яким довірятимуть, ще багато чого треба зробити.

Громадяни можуть скаржитися на шкоду, завдану їм ШІ

У ЄС буде створена Європейська адміністрація з ШІ для забезпечення впровадження та виконання вимог і приписів (до речі, там є відкриті вакансії). Завдяки новому законодавству громадяни можуть подавати до Адміністрації скарги на ШІ-системи, якщо вважають, що ті завдали їм шкоди, а також отримувати роз’яснення, чому система ухвалила те чи інше рішення.

Це – важливий крок у напрямку повернення людям суб’єктності в надзвичайно автоматизованому світі. Водночас це вимагає від самих користувачів принаймні мінімального рівня технологічних знань, щоб зрозуміти, що ситуація спровокована саме штучним інтелектом. Для більшості наразі це дуже розмиті та незрозумілі речі.

ШІ-компанії змушені бути більш прозорими

Більшість випадків використання технології не вимагатимуть відповідності нормам Закону про ШІ. Лише компанії, що розроблятимуть продукти в секторі «високого ризику» (критична інфраструктура чи охорона здоров’я), матимуть нові зобов’язання після того, як за три роки всі норми закону почнуть діяти. Ці зобов’язання передбачають краще управління даними, гарантування людського контролю за алгоритмами та надання пояснень, як системи можуть загрожувати правам людини.

Компанії, які розробляють «ШІ моделі загального призначення» (наприклад, великі мовні моделі) будуть зобов’язані готувати та зберігати технічну документацію: з описом процесу побудови моделі, поясненнями щодо авторських прав; а також тримати у вільному доступі пояснення, які дані були використані для навчання ШІ-моделі.

Ці норми різко змінюють поточний статус-кво, за якого технологічні компанії не розповідають, де і які дані вони брали, – тепер доведеться навести лад у галузі управління даними, у якій сам чорт спіткнеться.

Читайте також: Нащадки Тьюрінга. Що відбувалося на саміті зі штучного інтелекту в Блечлі-парку

Компанії з найпотужнішими ШІ-моделями, як-то GPT-4 (OpenAI) або Gemini (Google), зустрінуться з більш обтяжливими вимогами. Їм доведеться впроваджувати процеси оцінки роботи моделей, оцінювати ризики, гарантувати кібербезпеку та повідомляти про будь-які інциденти, у яких ШІ-системи схибили. Компанії, що проігнорують вимоги, отримають неймовірні штрафи або їхні продукти будуть заборонені в ЄС.

Варто також зазначити, що розробники моделей із відкритим кодом також мають оприлюднити покроковий алгоритм створення моделі, включно з архітектурою продукту, параметрами й умовами побудови (зокрема, мають розповідати про «вагу» – числові значення, що їх мають зв’язки між нейронами в нейронній мережі та впливають на пріоритетність однієї інформації перед іншою). Якщо вони все це опублікують, то майже звільняються від контролю з боку Закону про ШІ.

Хід «глибоко занепокоєних»

21 березня Генеральна Асамблея ООН одноголосно ухвалила свою першу спробу врегулювання галузі штучного інтелекту. Очолили процес США й уряди понад 100 держав. Документ впроваджує базові вимоги до ШІ стосовно захисту прав людини, фіксує його підзвітність міжнародному праву та вимагає посиленої конфіденційності. Документ не має санкційної частини й має дорадчий характер.

На відміну від постанов щодо обстрілів об’єктів інфраструктури та вбивства цивільних, резолюція щодо технології, на якій мало хто з голосувальників розуміється, виявилася «здатною переступити геополітичні розділи, які є в ООН», заявили в Білому домі.

Якщо ви дочитали цей матеріал до кінця, ми сподіваємось, що це значить, що він був корисним для вас.

Ми працюємо над тим, аби наша журналістська та аналітична робота була якісною, і прагнемо виконувати її максимально компетентно. Це вимагає і фінансової незалежності.

Станьте підписником Mind всього за 196 грн на місяць та підтримайте розвиток незалежної ділової журналістики!

Ви можете скасувати підписку у будь-який момент у власному кабінеті LIQPAY, або написавши нам на адресу: [email protected].